AI maakt een stormachtige ontwikkeling door, maar het beheersen van risico’s van AI-systemen gaat in een ander tempo. Waakzaamheid van burgers, bestuurders en volksvertegenwoordigers is daarom geboden. Dat schrijft de Autoriteit Persoonsgegevens (AP) in de nieuwe Rapportage AI- & Algoritmerisico’s Nederland. En… de AP kondigt ook de overgangsfase aan naar een AI-verordening!

▼

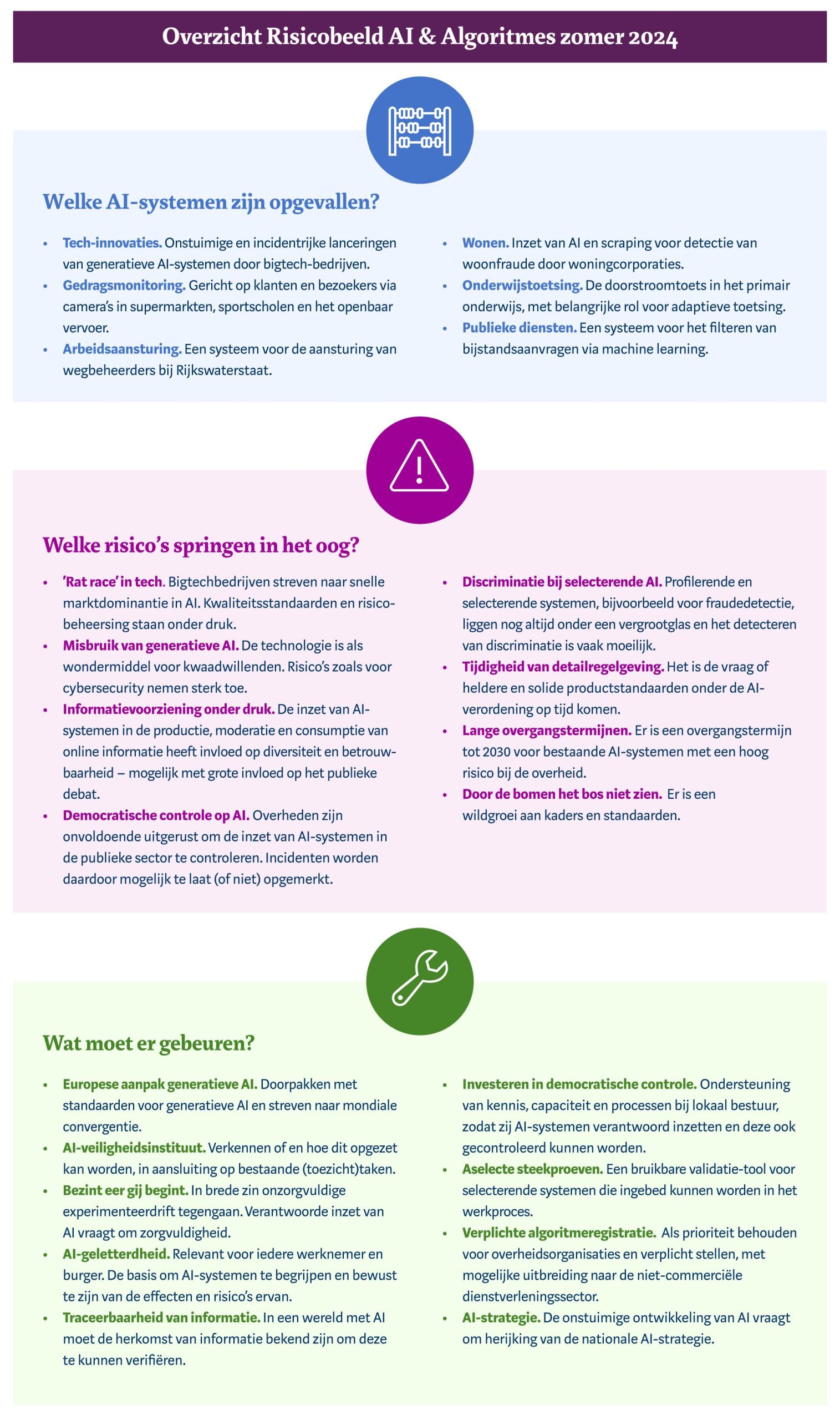

In Nederland is het vertrouwen in AI lager dan in andere landen. Mensen zullen de risico’s van AI-systemen steeds vaker tegenkomen in hun dagelijks leven. Van misbruik van generatieve AI voor cyberaanvallen en deepfakes tot nieuwe vormen van privacyschendingen en de kans op discriminatie en willekeur. Aan het eind van dit artikel staat een overzicht van risico’s en aanpak.

Een voorbeeld van een maatregel die helpt om meer grip te krijgen op de inzet van AI-systemen is de zogenoemde aselecte steekproef. Veel AI-systemen worden gebruikt om mensen te profileren en te selecteren. Bijvoorbeeld voor onderzoek naar fraude. In dat soort processen helpen aselecte steekproeven om discriminatie te ontdekken en tegen te gaan.

Stapsgewijs naar nieuwe AI-vereisten

De AP meldt in de rapportage ook het nodige over het overgangsregime naar de Europese AI-verordering. De overgangsfase begint op 1 augustus. Voor bedrijven, overheden en andere organisaties die met AI-systemen werken, is dit, volgens de AP, hét moment om te starten met voorbereidingen om systemen en organisaties compliant te maken. Nu de vereisten vaststaan, zullen de verschillende onderdelen van de verordening stapsgewijs – maar snel – in werking treden. Het eerste grote onderdeel omvat de bepalingen waarmee bepaalde AI-toepassingen worden verboden op de Europese markt. Dit onderdeel treedt in februari 2025 in werking. Op hoofdlijnen zullen tussen februari 2025 en augustus 2027 ook de vereisten uit andere onderdelen van kracht worden. Voor een werkbare naleving van deze vereisten moet nog veel geregeld en verduidelijkt worden, op nationaal én Europees niveau. Veel begrippen en procedures uit de AI-verordening vragen om nadere uitleg of invulling. Ook moet duidelijk worden hoe ontwikkelaars met Europese standaarden kunnen voldoen aan de eisen aan hoog-risico AI-systemen. Verder moet het toezicht op AI-systemen op nationaal niveau snel en met voldoende middelen worden ingericht

Check eigen AI-systemen

Aanbieders en gebruikers van AI-systemen wordt aangeraden direct te starten met een implementatieplan en het opzetten van het interne risicomanagement. Een eerste stap daarbij is het in kaart brengen van de systemen die zij ontwikkelen of gebruiken en of die vallen binnen de definitie van ‘AI-systeem’ in de verordening. Vervolgens moeten zij meestal een inschatting maken of deze systemen in een van de volgende risicogroepen vallen:

Verboden AI. Deze systemen moeten uit de handel genomen worden en het gebruik ervan moet worden gestopt. De bepalingen over verboden AI zijn vanaf februari 2025 al van kracht. Ook is de kans groot dat met deze systemen nu al de wet wordt overtreden, zoals wetgeving op het gebied van gelijke behandeling, privacy of arbeidswetgeving.

Hoog-risico-AI. Deze systemen moeten voldoen aan de eisen aan onder andere risicobeheer, de kwaliteit van de gebruikte data, technische documentatie en registratie, transparantie en menselijk toezicht. Voor overheden of uitvoerders van publieke taken gelden soms aanvullende vereisten, zoals het uitvoeren van een ‘grondrechteneffectbeoordeling’.

AI met een beperkt risico. Voor systemen die bedoeld zijn om met personen in contact te komen of die inhoud genereren, zoals deepfakes, gelden transparantieverplichtingen. Als deze systemen worden aangeboden of gebruikt, moeten mensen daarover worden geïnformeerd.

Wat gebeurt er met de data?

Gebruikers van AI-systemen kunnen alvast inschatten of hun AI-systemen voldoen of zullen voldoen aan de AI-verordening. Zij kunnen bij aanbieders informeren in hoeverre de gebruikte AI al voldoet aan de eisen. Bij de aanschaf van een AI-systeem is het zaak om de inkoop voorwaarden te controleren en bijvoorbeeld ook goed te letten op wat er gebeurt met data die het AI-systeem verwerkt en hoe de rechten op die data zijn geregeld. Er wordt ook gewerkt aan model-contractbepalingen voor de aanbesteding van AI in de publieke sector vanuit de Europese public buyers community.

Rol en verantwoordelijkheid

Rollen en verantwoordelijkheden in de AI-verordening kunnen overlappen en verschuiven. Zowel aanbieders als gebruikers moeten aan bepaalde verplichtingen voldoen. Organisaties die zelf AI-systemen ontwikkelen en gebruiken, vervullen in wezen beide rollen en moeten zich dan ook aan alle verplichtingen houden. De rollen kunnen ook verschuiven. Wordt een ingekocht systeem aangepast of voor een ander doel gebruikt? Dan kan een organisatie een aanbieder worden van een systeem, die zich dan bijvoorbeeld aan de regels voor hoogrisicosystemen moet houden. Gebruikers van AI-systemen wordt aangeraden goed in de gaten te blijven houden of (en zo ja, hoe) zij zelf bijdragen aan de ontwikkeling van de AI-systemen die zij gebruiken.

Regulatory sandbox

Ontwikkelaars van AI-systemen kunnen terecht in de Nederlandse testomgeving voor de regelgeving, ook wel regulatory sandbox genoemd. De AP, de Rijksinspectie Digitale Infrastructuur (RDI) en het ministerie van EZK werken aan de voorbereiding van de sandbox. Aanbieders kunnen hier in de loop van 2026 terecht om compliance-vragen over de AI-verordening op te lossen. Tot die tijd testen de toezichthouders in pilots de werking van de sandbox en sandboxtrajecten.

Download hier het volledige rapport.